Equilibrar el riesgo y la recompensa de ChatGPT, como un modelo de lenguaje grande (LLM) y un ejemplo de IA generativa, comienza realizando una evaluación de riesgos del potencial de una herramienta tan poderosa para causar daño. Considera lo siguiente.

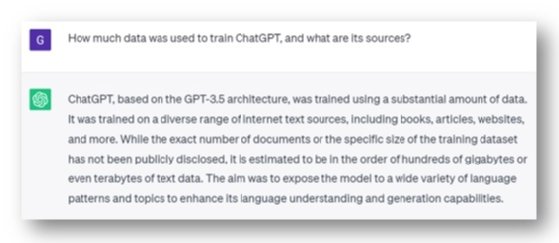

Capacitación de ChatGPT

Italia y Alemania aparecieron en los titulares de ChatGPT: “OpenAI supuestamente procesó datos personales sin informar a los usuarios y a las personas y puede carecer de una base legal para la extensa recopilación de datos utilizada para entrenar sus modelos de IA”. Según ChatGPT, se entrenó en una amplia gama de fuentes de Internet, donde OpenAI puede argumentar que los datos de entrenamiento son de dominio público. Este argumento puede no funcionar.

Por ejemplo, Clearview AI una vez ofreció servicios de reconocimiento facial a las agencias policiales canadienses y entidades del sector privado. Sin embargo, el Comisionado de Privacidad de Canadá y varias oficinas de privacidad provinciales descubrieron que había infringido las leyes de privacidad federales y provinciales al recopilar imágenes en línea de acceso público de personas (y niños) sin su conocimiento o consentimiento, con los datos utilizados de formas no relacionadas con su original. objetivo. En otras palabras, el hecho de que algunos datos sean públicos no significa que sean gratuitos para todos. Dado que no se habrá otorgado ninguna autorización para un nuevo propósito para el uso de datos personales confidenciales, esto se vio como una violación.

También existe un riesgo de seguridad debido a la corrupción intencional de los datos de capacitación que afectaría las respuestas de ChatGPT.

Respuesta: ¿Regulaciones más estrictas con consecuencias por incumplimiento? ¿Mayor transparencia de la IA? ¿Supervisión de los procesos de datos de entrenamiento? ¿Mayor colaboración equilibrada entre propietarios de tecnología y grupos de interés público? Como se detalla en un artículo de Al Jazeera sobre los riesgos sociales de la IA generativa: “Sam Altman, director ejecutivo de OpenAI de ChatGPT, testificó ante los miembros de un subcomité del Senado… sobre la necesidad de regular la tecnología de inteligencia artificial cada vez más poderosa que se crea dentro de su empresa y otras. como Google y Microsoft”.

Indicaciones de ChatGPT

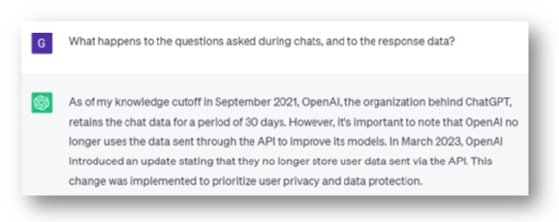

Open AI (creador de ChatGPT) una vez almacenó datos de chat durante 30 días, algunos de los cuales se utilizaron para mejorar sus modelos. Según ChatGPT, OpenAI dejó de hacer esto a partir de marzo de 2023, “para priorizar la privacidad del usuario y la protección de datos”.

Además, los datos de chat capturados antes de marzo de 2023 estaban sujetos a una política de retención de 30 días. Nota: Las políticas de uso y retención de datos de OpenAI deben estudiarse como parte de una evaluación de riesgo cibernético adecuada en lugar de depender de una respuesta de ChatGPT.

Otro riesgo de seguridad cibernética es similar a dar datos corporativos confidenciales a una entidad desconocida, como cuando un usuario envía datos corporativos confidenciales a ChatGPT para su análisis. Esto es una infracción, y el riesgo de terceros exacerba el alcance de la infracción. Los riesgos incluyen pasar datos a un sistema de terceros sin la diligencia debida adecuada y no asignar autoridades de nivel de sistema debidamente monitoreadas para ello.

¿Y qué pasa con las herramientas de terceros que usan OpenAI como plataforma? Esta abstracción plantea riesgos como políticas contradictorias entre la plataforma y la herramienta y diferencias en los enfoques de almacenamiento de chat y respuesta. Esto significa realizar la diligencia debida no solo en OpenAI sino también en la herramienta de abstracción. También existe el riesgo de seguridad de que un aviso se modifique o se redirija de otro modo una vez enviado en cualquier nivel, lo que resultará en la devolución o realización de acciones no deseadas.

Respuesta: Actualizar y comunicar las políticas corporativas de seguridad de datos. Verifique los controles de acceso para garantizar su idoneidad. Mejorar/aplicar procesos de diligencia debida de terceros. Además, al igual que la diferenciación entre la nube pública y la nube privada, los chatbots públicos pueden evolucionar a chatbots privados para permitir el lanzamiento más seguro de las capacidades de ChatGPT en las empresas.

Respuestas de ChatGPT

ChatGPT puede ser utilizado por personas desagradables para tener conversaciones telefónicas o por correo electrónico de tal calidad que generen confianza con un objetivo humano vulnerable para entregar las llaves de su cuenta bancaria o exponer sus datos de identificación nacional. ChatGPT facilita la ingeniería social, uno de los mayores riesgos cibernéticos, al dificultar la identificación de si una conversación es legítima.

Hoy en día, los cursos de concientización sobre seguridad cibernética enseñan a verificar la ortografía, la gramática y las anomalías conversacionales como un medio para identificar correos electrónicos de phishing. Para las llamadas telefónicas, dicha formación puede incluir la solicitud de las credenciales de la persona que llama y su verificación. Sin embargo, para la persona promedio, si las señales de alerta típicas no aparecen, ¿cuántas pueden ser inducidas a creer incorrectamente que esas conversaciones son confiables?

También existe el riesgo de una dependencia excesiva de las respuestas de ChatGPT, especialmente cuando se aplica en un entorno de seguridad, amplificando los datos de entrenamiento y los riesgos de alerta planteados anteriormente. Por lo tanto, poner las respuestas en acción sin verificación puede exponer a una organización a nuevos riesgos de seguridad.

Respuesta: Para los correos electrónicos, una bandera roja sigue siendo clave: el dominio de correo electrónico de origen. Verifique los números de teléfono y valide la identidad de la persona que llama. Además, la capacitación de concientización sobre seguridad cibernética corporativa debe cubrir las herramientas de IA conversacionales. Valide las respuestas de ChatGPT en escenarios críticos antes de actuar sobre ellos. El pensamiento crítico es más importante que nunca.

Conclusión

Este artículo exploró tres grupos de problemas de seguridad cibernética que surgen del uso de ChatGPT. La naturaleza incipiente de ChatGPT significa que se espera que cambie rápidamente y siga cambiando. No mantenerse al día con estos cambios introducirá más riesgos y algunos controles dejarán de ser útiles. Como siempre, el control de riesgos para la eficacia del control es su revisión frecuente, especialmente en entornos de rápida evolución.

El ex director ejecutivo de Google, Eric Schmidt, advierte que los sistemas de IA de hoy pronto podrán realizar exploits de día cero y que EE. UU. no está preparado para un mundo de IA. En última instancia, hay un mundo completamente nuevo de problemas de seguridad cibernética por venir, corporativos y soberanos, a medida que usamos una nueva generación de herramientas de IA. Si bien hay mucho que no sabemos, es mejor ser proactivo frente a estas nuevas amenazas mientras la IA generativa aún está en pañales.

Guy Pearce es miembro del Grupo de Trabajo de Tendencias Emergentes de ISACA.